视频解析网站是怎么做的/大连网站建设费用

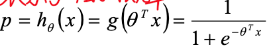

Logistic回归最后一层是sigmoid

Softmax回归最后一层是softmax:

Logistic回归

主要应用于二分类问题,回归问题的表达式: , 将得到的y值经过sigmoid函数转化为二分类问题.

表示y=1的概率,

表示y=1的概率,

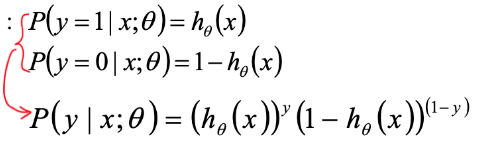

其中![]()

单个样本的概率分布:

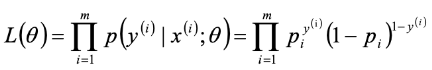

m个样本的概率分布 --> 似然函数:

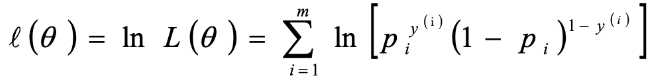

对数似然函数:

损失函数:

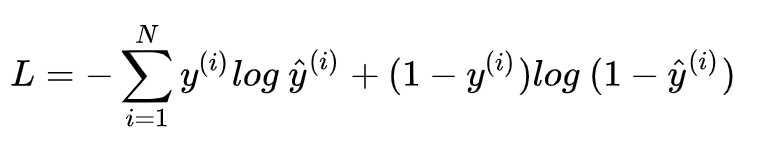

二分类交叉熵损失:

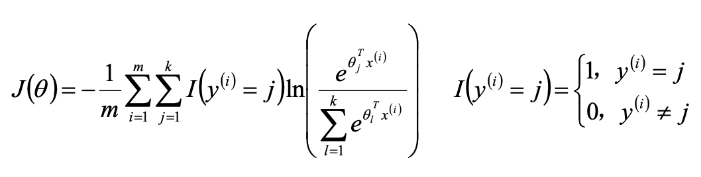

多分类交叉熵损失:

Ref:https://www.zhihu.com/question/341500352/answer/795497527

对数损失函数:就是把所有二分类交叉熵损失取均值。

Ref:https://blog.csdn.net/qq_38625259/article/details/88371462

深入理解交叉熵损失/对数损失:https://zhuanlan.zhihu.com/p/52100927

Softmax回归

softmax 回归主要解决的是K分类的问题, 向量 将样本分为第一类和其他; 向量

将剩余的样本分为第二类和其他....

是一个k*n 的二维矩阵,将样本分成k类.

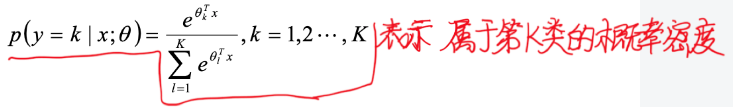

单个样本的概率分布:

下式中 得到的是一个k维列向量,元素分别表示该样本属于每一类的概率

损失函数: